“Mô hình ngôn ngữ lớn Llama 4 đang trong quá trình phát triển. Chúng tôi huấn luyện nó trên cụm máy chủ sử dụng hơn 100.000 chip H100, nhiều hơn mọi hệ thống từng được công bố trên truyền thông”, CEO Meta Mark Zuckerberg nói trong cuộc họp về doanh thu quý III/2024 tuần này.

Ông không tiết lộ chính xác số lượng H100 mà Meta đang sở hữu. Trên thị trường, mỗi chip Nvidia H100 có giá 30.000-40.000 USD, đồng nghĩa cụm máy chủ của Meta giá trị hơn 4 tỷ USD nếu chỉ tính riêng tiền mua GPU.

Con số 100.000 mà Zuckerberg nhắc đến được cho là để so sánh với siêu máy tính Colossus, do startup xAI của tỷ phú Elon Musk triển khai từ mùa hè. Ông chủ Tesla khi đó mô tả đây là siêu máy tính lớn nhất thế giới, được trang bị 100.000 chip H100 để huấn luyện chatbot Grok.

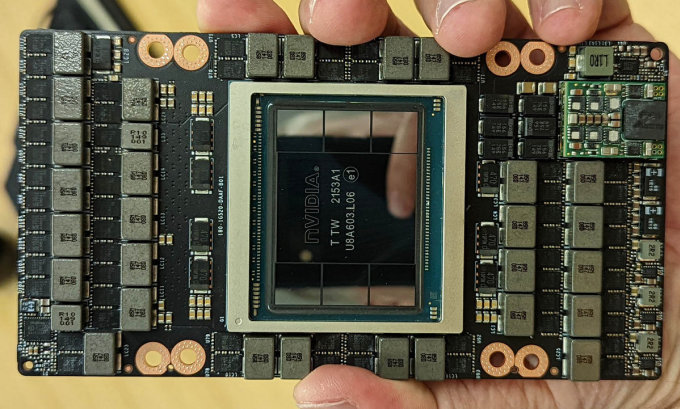

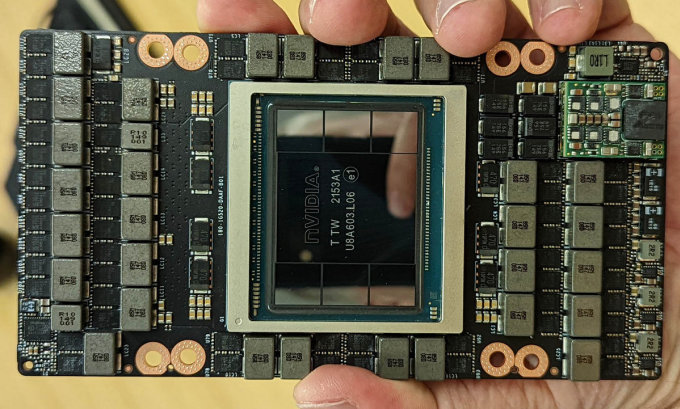

Card gắn chip Nvidia H100. Ảnh: Serve The Home

Zuckerberg tuyên bố Llama 4 sẽ có năng lực và khả năng suy đoán mạnh hơn, đồng thời nhanh hơn nhiều so với những mô hình trước đó. “Mô hình nhỏ của nó có thể được phát hành đầu năm 2025”, ông nói.

Số lượng chip H100 mỗi công ty sở hữu đang trở thành yếu tố được xem xét khi tuyển dụng và thu hút nhân tài. CEO Perplexity Aravind Srinivas tiết lộ thông tin này khi ông tìm cách tuyển một nhà nghiên cứu cấp cao từ Meta.

“Các vị biết nhà nghiên cứu đó nói gì không? Ông ấy bảo: Hãy quay lại tìm tôi khi công ty có 10.000 chip H100”, Srinivas kể.

Elon Musk hồi đầu tuần cũng thông báo xAi sẽ sớm mở rộng gấp đôi hệ thống máy chủ, tăng số lượng chip H100 và H200 lên khoảng 200.000 trong vài tháng tới.

GPU H100 là bản kế nhiệm của A100 giá 10.000 USD và được mệnh danh là “ngựa thồ” của ngành trí tuệ nhân tạo”. Trong huấn luyện AI, GPU chiếm ưu thế so với CPU nhờ khả năng tiến hành song song hàng loạt tính toán. Các nhà phát triển đang sử dụng A100 và H100 để xây dựng mô hình ngôn ngữ lớn (LLM), cốt lõi của ứng dụng AI như ChatGPT.

Hiện GPU của Nvidia được đặt mua nhiều nhất, trong khi các hãng khác như AMD cũng đã tung ra sản phẩm tương tự.

Điệp Anh (Theo Business Insider, Reuters)