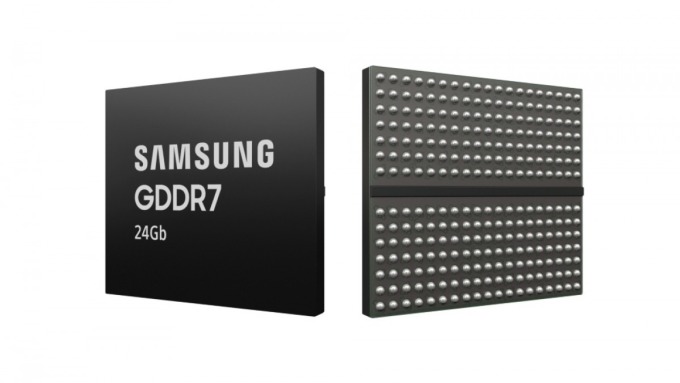

Bộ nhớ RAM GDDR7 24 Gb (3 GB) đầu tiên trên thế giới của Samsung có tốc độ 42,5 Gbps hỗ trợ các GPU thế hệ mới.

Lưu trữ thẻ: trí tuệ nhân tạo

ChatGPT cũng là công cụ AI tạo sinh duy nhất vượt quá 1 tỷ lượt truy cập trang web.

Hà NộiCác công nghệ mới nổi như trí tuệ nhân tạo, điện toán đám mây, blockchain… sẽ khuyến khích chuyển giao và doanh nghiệp được hưởng ưu đãi khi thực hiện.

AnhĐộng vật tại Bảo tàng Động vật học, Đại học Cambridge có thể trò chuyện với khách tham quan qua điện thoại nhờ ứng dụng trí tuệ nhân tạo